Als Product Lead bei Mayflower wollte ich herausfinden, wie weit man KI heute wirklich im Produktalltag einsetzen kann. Nicht theoretisch, sondern unter realen Bedingungen: Können wir Ideen schneller validieren? Entsteht tatsächlich produktionsfähiger Code? Und wie viel Arbeit spart man dadurch im Vergleich zu einem klassischen Setup?

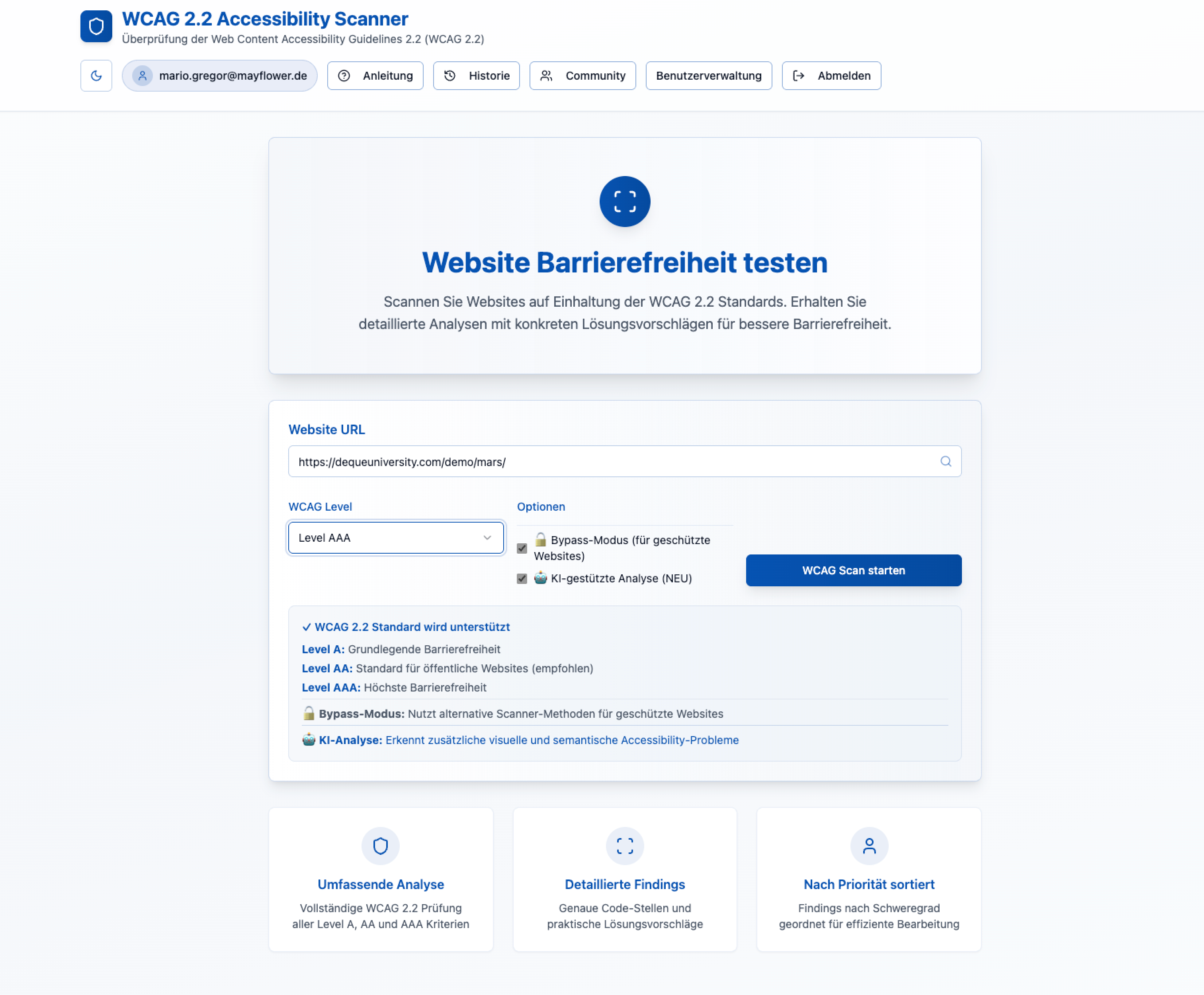

Lovable habe ich dabei nicht als Dienstleister erlebt, sondern als Werkzeug: ein KI-basiertes Full-Stack-System, das aus klar formulierten Anweisungen klickbare Prototypen, Integrations-Stubs und erste Backend-Teile erzeugt. Das Ziel war klar: ein Tool entwickeln, das Webseiten auf WCAG-2.1-Konformität prüft — inklusive geschützter Bereiche. Und weil Teams diese Frage oft stellen: Ein WCAG-Scanner braucht im Kern Zugriff auf die zu prüfenden Seiten, sauber extrahierte HTML-Dumps und Kontextinformationen für das Reporting; bei geschützten Bereichen zusätzlich ein stabiles Crawling- und Consent-Handling.

Kurze Unterbrechung – wo wir unsere Erfahrung sammeln

Mayflower Labs

Wir arbeiten nicht nur intensiv an KI-Projekten, sondern setzen auch massiv auf R&D. Unsere R&D-Projekte werden aber nicht in Schubladen verstaut. Sie lösen echte Kundenprobleme und fließen direkt in produktionsreife Lösungen ein.

Schon in den ersten Tagen wurde deutlich, wie schnell Lovable Mehrwert liefert. Prototypen entstehen in Minuten, sodass Hypothesen unmittelbar überprüft werden können. Trotzdem bleibt klar: KI ersetzt nicht das Produktdenken. Die richtigen Fragen, saubere Hypothesen und ein gutes Validierungsdesign sind weiterhin entscheidend.

Warum KI hier sinnvoll war

In der Accessibility-Domäne steckt viel repetitive Entwicklungsarbeit – wiederkehrende Prüfpfade, Boilerplate-Code, Standardlogik. Genau hier spielt KI ihre Stärken aus. Sie übernimmt Fleißarbeit und ermöglicht eine extrem schnelle Exploration. Der erste klickbare Prototyp war innerhalb weniger Minuten fertig. Dadurch konnten wir ohne großen Aufwand Annahmen verwerfen oder bestätigen. Schnelleres Feedback, weniger Risiko, mehr Fokus auf das Wesentliche.

Gleichzeitig wurde offensichtlich, dass KI nur dann richtig funktioniert, wenn das Umfeld stimmt. Prompt-Hygiene, klare Ziele, Versionskontrolle und eine teamweite Abstimmung sind nicht plötzlich weniger wichtig, nur weil die KI viel erzeugt.

Lovable und der restliche technische Stack im Überblick

Die Technologie-Entscheidungen ergaben sich direkt aus den Projektanforderungen:

- Authentifizierung und Kommunikation: Wir nutzten Resend für Authentifizierung und E-Mail-Versand. Ein schlankes Tool, das sich gut automatisieren lässt.

- Crawling auch geschützter Bereiche: Um schwer erreichbare Seiten zu erfassen, setzten wir Firecrawl ein. Für unsere Aufgabe war das essenziell, denn viele relevante Accessibility-Fälle liegen hinter Logins.

- Reproduzierbare WCAG-Prüfungen: Für verlässliche Ergebnisse nutzten wir Axe-Core. Das sorgt dafür, dass die Prüfschritte deterministisch und nachvollziehbar bleiben — keine „wahrscheinlich richtigen“ KI-Urteile, sondern Industriestandard.

- Lovables Rolle im Zusammenspiel: Lovable war die Engine, die schnell Prototypen baut, Integrations-Stubs liefert und per Chat-/Editor-Interface schnelle Anpassungen ermöglicht. Besonders am Anfang entsteht ein massiver Geschwindigkeitsschub.

Technische Erkenntnisse aus dem Lovable-Projekt

Mit der Zeit kristallisierten sich drei Punkte heraus, die entscheidend wurden. Erstens: Präzise Prompts sparen Nerven. Unklare Anweisungen führten mehrfach dazu, dass die KI Artefakte erzeugte, die nicht stabil waren. Wir mussten teilweise mehrere Schleifen durchlaufen, weil der Kontext nicht sauber formuliert war.

Zweitens zeigte sich, dass Dokumentation kein Nice-to-Have ist. Prompts, Entscheidungen und Integrationsdetails im Repository zu sammeln, hat uns später viel Sucherei erspart. Wer KI nutzt, muss den eigenen Prozess genauso sorgfältig dokumentieren wie beim klassischen Coding.

Drittens ist klar geworden, dass deterministische Prüfungen unverzichtbar sind. Gerade bei Accessibility kann man sich nicht auf Wahrscheinlichkeiten der KI verlassen – jede Prüfung muss durch feste Standards verifiziert werden. Axe-Core hat diesen Job zuverlässig übernommen.

Wo Lovable punktet – und wo es knifflig wird

Besonders in der frühen Product-Phase hat Lovable uns massiv beschleunigt. Innerhalb weniger Minuten hatten wir ein Interface, konnten Nutzertests starten und viel schneller als sonst entscheiden, in welche Richtung sich die Lösung entwickeln sollte. Das erhöhte nicht nur die Iterationsgeschwindigkeit, sondern auch die Motivation im Team.

Auf der anderen Seite wurden typische Fallstricke sichtbar. Der erste Wow-Moment verblasst, sobald man tiefer in die Implementierung eintaucht, weil kleine Ungenauigkeiten im generierten Code sich schnell summieren. Prompts, die nicht glasklar sind, führen zu endlosen Rückfragen der KI. Und der Übergang von „schnell generiert“ zu „sauber produktionsfähig“ bleibt weiterhin ein manueller Aufwand.

Viele fragen an der Stelle, wann man Tools wie Lovable lieber nicht einsetzen sollte. Die Antwort ist ziemlich eindeutig: Bei sicherheitskritischen oder stark regulierten Anwendungen ohne etablierten Audit-Pfad. Dort ist ein klassisches Setup mit klaren Kontrollpunkten oft die bessere Wahl.

Was Entscheider unbedingt bedenken sollten

Aus CEO- oder CTO-Perspektive stellt der Einsatz solcher Tools einige strategische Fragen.

Kosten, ROI und Time-to-Market

Bevor man investiert, sollte man ehrlich prüfen:

- Verkürzt sich die Time-to-Market messbar?

- Bleibt die Qualität stabil oder steigt sie sogar?

- Lassen sich Entwicklungskosten senken, weil Ideen schneller validiert werden?

Nur wenn diese Effekte sich quantifizieren lassen, lohnt der Einsatz auf Unternehmensebene.

Qualität, Sicherheit und Audit

Qualität und Sicherheit sind weitere zentrale Aspekte auf Management‑Ebene. Automatisch erzeugter Code kann Schwachstellen oder Lizenzprobleme enthalten; ein CEO sollte sicherstellen, dass vor dem Deployment automatisierte Code‑Audits, statische Analysen und menschliche Reviews Pflicht sind. Ohne solche Gates droht das Risiko, dass sich Fehler oder Sicherheitslücken in den produktiven Betrieb einschleichen. Für sensible oder regulierte Anwendungen ist daher eine besonders strikte Abstufung der Freigaben unerlässlich.

Abhängigkeit von Modell-Providern

Auch die Abhängigkeit von externen Modell‑Providern ist strategisch relevant. Lovable orchestriert mehrere große Modelle und Dienste; Preis‑ oder API‑Änderungen bei diesen Providern können Kosten schnell steigen lassen. Unternehmen sollten daher ein Konzept für Vendor‑Fallbacks und gegebenenfalls eigene Modellalternativen prüfen. Parallel braucht es Operationalisierungs‑Kapazitäten: erzeugter Code muss im produktiven Betrieb robust laufen, Monitoring für Modell‑Drift etabliert sein und SRE‑Ressourcen gegebenenfalls aufgestockt werden.

Datenschutz und Compliance

Datenschutz und Compliance dürfen nicht nachrangig behandelt werden. Bevor man produktiv crawlt oder Nutzerdaten an Modelle sendet, muss geklärt sein, welche Daten wohin fließen, welche Verträge und DPAs bestehen und wie Consent‑Mechanismen technisch umgesetzt werden. Beim Crawling geschützter Bereiche ist besonders auf rechtliche Rahmenbedingungen und Anonymisierung zu achten.

Auswirkungen auf die Organisation

Schließlich betrifft der Einsatz solcher Tools auch die Organisation. Product Owner, Entwickler und Legal müssen gemeinsam Verantwortung übernehmen. Ein CEO sollte klären, welche Skills intern aufgebaut werden müssen – etwa Prompt‑Engineering, Evaluationsmethodik und KI‑Monitoring – und wer die Entscheidungen über Modell‑Outputs trifft. Ohne klare Zuständigkeiten entstehen Verzögerungen und Unsicherheit.

Meine Empfehlung: Mit einem gezielten Pilot starten

Meine konkrete Empfehlung lautet: Nicht großflächig blind an den Start gehen, sondern mit einem klar definierten Pilot beginnen. Dieser Pilot sollte zwei Use‑Cases haben, klare KPIs messen (Time‑to‑first‑feedback, Deploy‑Frequency, Fehler‑Rate nach Release, Kosten pro Feature) und eine Laufzeit von etwa 30 bis 90 Tagen nicht überschreiten. Zwischen Lovable‑Output und Live‑Deployment sollte ein Governance‑Layer eingefügt werden, der Security‑Scans, Compliance‑Checks und menschliche Reviews umfasst. Parallel dazu sind Budget‑Guardrails für Token‑ oder API‑Nutzung sinnvoll, ebenso wie Verträge und Datenschutzprüfungen.

TL;DR

Lovable hat mir als Product Lead ermöglicht, extrem schnell funktionierende Prototypen zu erstellen und Hypothesen früh zu validieren. Aus agiler Sicht erhöht sich die Iterationsgeschwindigkeit des Teams deutlich. Gleichzeitig bleibt für mich klar, dass Governance, Sicherheit und Budgetkontrolle von Anfang an mitgedacht werden müssen, damit der Einsatz solcher Tools nachhaltig wirkt.

Wenn du tiefer einsteigen möchtest oder eine strukturierte 30/60/90-Pilotroadmap brauchst, melde dich gern für einen Austausch.

Schreibe einen Kommentar